Úprava CE filtrů na VGA výstupech

Kdysi velmi, velmi dávno jsem pojal podezření, že grafické (a další) karty obsahují i součásti, jenž se tak docela a úplně neslučují s přáním zákazníka mít co nejkvalitnější obraz. To když jsem si četl o normách vyzařování EMI (Electro Magnetic Interference) a jejich měření a zkoušení. Došlo to tak daleko, že karta bez drahého CE EMI testu se nedá prodávat...

Proč by to každého uživatele používajícího VGA výstup mělo zajímat? Inu, protože tyto filtry sice umožní kartě se vměstnat do velmi přísné EMI hranice vyzařování, nicméně za cenu poškození frekvenčního spektra výstupního signálu. Přeloženo do češtiny - obraz bude rozmazanější než by mohl být. Míra rozmazanosti závisí na použitém rozlišení a obnovovací frekvenci. Čím vyšší rozlišení a frekvence, tím je to horší. Kvalitní CE filtry (typicky Matrox karty) zvládají víc, ale stále je nejlepší žádný filtr než i velmi kvalitní filtr.

Co se tedy bude upravovat jsou CE výstupní filtry na grafických kartých, respektive na jejich VGA výstupech. Úprava je jednoduchá, odstraňují se.

Dlouho jsem na toto téma nic nenapsal, protože když jsem s tímto nápadem poprvé příšel někdy kolem roku 1992 či 1993, tak se jednalo o grafickou kartu pro Amigu a sice CyberVision64/3D s "úžasným" Virge čipem. Ta měla CE filtry tak odfláknuté, že vyšší rozlišení (1024x768) v rozumné obnovovací frekvenci (100Hz) bylo krutě rozmazané. Když jsem svůj nápad prezentoval na Amiga konferenci, tak se do mě pustili de-facto všichni přítomní a padaly "argumenty" jako že když to tam výrobce dal, tak to tam musí být. Nebo že si zničím grafiku, monitor či případně obojí. Další tvrdili že si zkrátím životnost svého hardware a tak dále. Už si ani přesně nepamatuji, co všechno mi říkali. Určitě jsem byl upozorňován, že po této úpravě také moje karta přestane vyhovovat CE normě vyzařování. To mě samozřejmě velice trápí :D

Zkráceně lze říci, že norma na vyzařování EMI je pro přídavné karty do PC tak nízká, že nutí výrobce k opravdu radikálním zásahům. Což se zpětně odráží v kvalitě výstupu... Můj argument byl, že takový CRT monitor (či pulzní zdroj) vyzařuje cirka 100 000x více EMI a nikomu to, zdáse, nevadí. Stejně tak to nevadilo mým oponentům, takže jsem od další diskuze upustil a věnoval jsem se realizaci svého nápadu.

Jak se dalo očekávat, úprava přinesla radikální zlepšení kvality a čistoty obrazu, čiže od té doby jsem ji provedl na VŠECH grafických kartách které jsem kdy používal. Byť jen na testování. Proste z principu a natruc pochybovačům. Monitor Eizo F35 (a další po něm, jako třeba Eizo F520) běžel s upravenými kartami od roku 1997 dodnes a ty starší monitory před ním také neutrpěly.

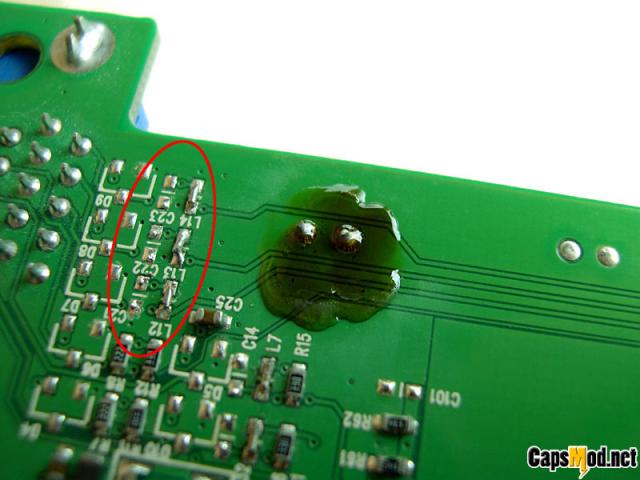

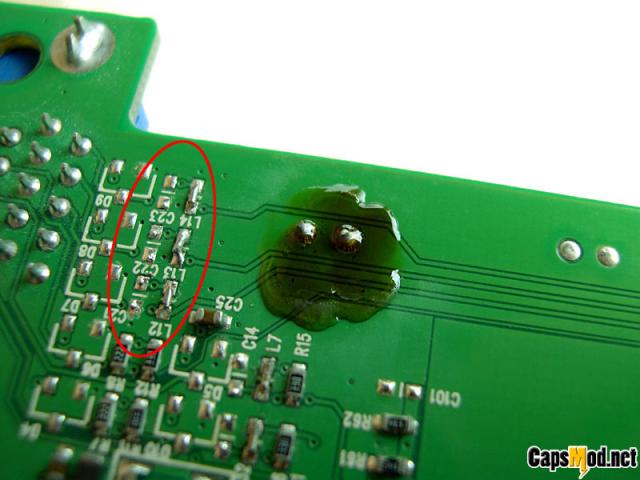

Nelze, bohužel, na toto téma napsat žádný důkladný návod. Každý výrobce a každá karta má CE filtry jinak řešeny. Je třeba jít po cestě RGB a V & H sync signálů od čipu ke VGA konektoru (či opačně, RGB jsou na pinech 1, 2 a 3, V sync je 14 a H sync je 13... pin 15 můžete odlomit, zabráníte detekci monitoru Windowsům takže další monitor se nebude zase instalovat... :) ) a odstranit kondenzátory z signálů na zem + odstranit a zkratovat tlumivky v cestě signálu. Typicky se jedná o jednu SMD tlumivku a dva SMD kondíky - před a za ní - blízko VGA konektoru.

PNY, třeba, používá velice kvalitní tlumivky s čtyřmi vývody - jejich odpajování je mírně řečeno porod. Klasické SMD součástky se odpajují VELMI snadno, stačí mít dvě mikropájky a přiložit je naráz z obou stran a... je to. Stejně tak pak zkratuji tlumivku mini-drátkem.

Pozor, neodstraňujte ty malé černé SMD tranzistorky (mají tři vývody) a odpory jdoucí z GPU na jejich bázi - jsou to regulátory intenzity signálu, když jim odstraníte ty odpory, přebudí Vám monitor :) Pokud nemáte monitor starý a vypálený, tak Vám tak ostré barvy nebudou po chuti :) Pokud máte starý a vypálený monitor, kupte si kvalitní 1% SMD odpory a zkuste snižit jejich hodnotu o 20, 30% oproti originálním... :)

Pokud jste úplní nadšenci, vyměňte i tyto tranzistory za rychlejší a s menším šumem = kvalitnější. Obraz Vaší grafiky se Vám odmění - úplně "prokvete" :)

Proč by to každého uživatele používajícího VGA výstup mělo zajímat? Inu, protože tyto filtry sice umožní kartě se vměstnat do velmi přísné EMI hranice vyzařování, nicméně za cenu poškození frekvenčního spektra výstupního signálu. Přeloženo do češtiny - obraz bude rozmazanější než by mohl být. Míra rozmazanosti závisí na použitém rozlišení a obnovovací frekvenci. Čím vyšší rozlišení a frekvence, tím je to horší. Kvalitní CE filtry (typicky Matrox karty) zvládají víc, ale stále je nejlepší žádný filtr než i velmi kvalitní filtr.

Co se tedy bude upravovat jsou CE výstupní filtry na grafických kartých, respektive na jejich VGA výstupech. Úprava je jednoduchá, odstraňují se.

Dlouho jsem na toto téma nic nenapsal, protože když jsem s tímto nápadem poprvé příšel někdy kolem roku 1992 či 1993, tak se jednalo o grafickou kartu pro Amigu a sice CyberVision64/3D s "úžasným" Virge čipem. Ta měla CE filtry tak odfláknuté, že vyšší rozlišení (1024x768) v rozumné obnovovací frekvenci (100Hz) bylo krutě rozmazané. Když jsem svůj nápad prezentoval na Amiga konferenci, tak se do mě pustili de-facto všichni přítomní a padaly "argumenty" jako že když to tam výrobce dal, tak to tam musí být. Nebo že si zničím grafiku, monitor či případně obojí. Další tvrdili že si zkrátím životnost svého hardware a tak dále. Už si ani přesně nepamatuji, co všechno mi říkali. Určitě jsem byl upozorňován, že po této úpravě také moje karta přestane vyhovovat CE normě vyzařování. To mě samozřejmě velice trápí :D

Zkráceně lze říci, že norma na vyzařování EMI je pro přídavné karty do PC tak nízká, že nutí výrobce k opravdu radikálním zásahům. Což se zpětně odráží v kvalitě výstupu... Můj argument byl, že takový CRT monitor (či pulzní zdroj) vyzařuje cirka 100 000x více EMI a nikomu to, zdáse, nevadí. Stejně tak to nevadilo mým oponentům, takže jsem od další diskuze upustil a věnoval jsem se realizaci svého nápadu.

Jak se dalo očekávat, úprava přinesla radikální zlepšení kvality a čistoty obrazu, čiže od té doby jsem ji provedl na VŠECH grafických kartách které jsem kdy používal. Byť jen na testování. Proste z principu a natruc pochybovačům. Monitor Eizo F35 (a další po něm, jako třeba Eizo F520) běžel s upravenými kartami od roku 1997 dodnes a ty starší monitory před ním také neutrpěly.

Nelze, bohužel, na toto téma napsat žádný důkladný návod. Každý výrobce a každá karta má CE filtry jinak řešeny. Je třeba jít po cestě RGB a V & H sync signálů od čipu ke VGA konektoru (či opačně, RGB jsou na pinech 1, 2 a 3, V sync je 14 a H sync je 13... pin 15 můžete odlomit, zabráníte detekci monitoru Windowsům takže další monitor se nebude zase instalovat... :) ) a odstranit kondenzátory z signálů na zem + odstranit a zkratovat tlumivky v cestě signálu. Typicky se jedná o jednu SMD tlumivku a dva SMD kondíky - před a za ní - blízko VGA konektoru.

PNY, třeba, používá velice kvalitní tlumivky s čtyřmi vývody - jejich odpajování je mírně řečeno porod. Klasické SMD součástky se odpajují VELMI snadno, stačí mít dvě mikropájky a přiložit je naráz z obou stran a... je to. Stejně tak pak zkratuji tlumivku mini-drátkem.

Pozor, neodstraňujte ty malé černé SMD tranzistorky (mají tři vývody) a odpory jdoucí z GPU na jejich bázi - jsou to regulátory intenzity signálu, když jim odstraníte ty odpory, přebudí Vám monitor :) Pokud nemáte monitor starý a vypálený, tak Vám tak ostré barvy nebudou po chuti :) Pokud máte starý a vypálený monitor, kupte si kvalitní 1% SMD odpory a zkuste snižit jejich hodnotu o 20, 30% oproti originálním... :)

Pokud jste úplní nadšenci, vyměňte i tyto tranzistory za rychlejší a s menším šumem = kvalitnější. Obraz Vaší grafiky se Vám odmění - úplně "prokvete" :)

Jen tak mimochodem EMI se u pc resi do znacne miry kejsem + platkem plisku mezi gk a kejsem samotnym. U Amigy bylo EMI stineni naprosto minimalni, pokud jsi mel klasicky hdd tak musel jit i ten (snad jediny) pryc protoze by se tam v drtive vetsine ani jinak nevesel (proto se do Amig daval v USA Seagate Medailist s nizkym profilem). Mrkni na formfactors.org je tam dost podrobne rozepsana specifikace EMI :thumb

/OT

[QUOTE]U Amigy bylo EMI stineni naprosto minimalni, pokud jsi mel klasicky hdd tak musel jit i ten (snad jediny) pryc protoze by se tam v drtive vetsine ani jinak nevesel[/QUOTE]

No, to je mirne zkresleni faktu. Amiga 1200 v desktop provedeni (takova vetsi klavesnice http://upload.wikimedia.org/wikipedia/commons/f/fc/Amiga_1200_Nahaufnahme.jpg ) byla originalne delana na notebokove 2,5" disky, ktere se tam originalne instalovaly. Jeden takovy jsem tam od AB Compu v Praze mel, 85MB Maxtor, jaro 1993... (dodneska ho mam, funguje)

Jine Amigy bud nebyly na pevny disk navrhovane (A500), nebo byly v poradne kejse (A1000, A2000, A3000, A4000). A600 byla resena na 2,5" jako A1200, a k A500 se disk dal pripojit spolu s CPU + ram pridavnou kartou z boku, dokonce jestli nebyl SCSI... ale to uz nevim jiste :) http://amiga.erkan.se/index.php/gvp-hd8-vintage-amiga-harddrive/ (kamarad to mel i s rozsirenim pameti a rychlejsim (68020 14MHz?) procesorem, take do GVP, jen ten vypinac na vrchu to nemelo :-)

Jenze 2,5" disky jsou pomale a drahe, takze kutilove odstranili z vnitrnosti Amigy jeden plisek (nad ramkami) a razem se tam dal zcela bezny 3,5" HDD s troskou komprese nacpat. Vsichni to tak meli a nebyli s tim zadne problemy - tedy krome potreby draheho redukcniho kabelu 2,5" - 3,5" IDE. Nebo 2x 3,5" IDE + kablik ven na CDROMku... :) To dokud jsem to nedal cele do toweru a bylo.

OT/

[QUOTE]U Amigy bylo EMI stineni naprosto minimalni, pokud jsi mel klasicky hdd tak musel jit i ten (snad jediny) pryc protoze by se tam v drtive vetsine ani jinak nevesel[/QUOTE]

No, to je mirne zkresleni faktu. Amiga 1200 v desktop provedeni (takova vetsi klavesnice http://upload.wikimedia.org/wikipedia/commons/f/fc/Amiga_1200_Nahaufnahme.jpg ) byla originalne delana na notebokove 2,5" disky, ktere se tam originalne instalovaly. Jeden takovy jsem tam od AB Compu v Praze mel, 85MB Maxtor, jaro 1993... (dodneska ho mam, funguje)

Jine Amigy bud nebyly na pevny disk navrhovane (A500), nebo byly v poradne kejse (A1000, A2000, A3000, A4000). A600 byla resena na 2,5" jako A1200, a k A500 se disk dal pripojit spolu s CPU + ram pridavnou kartou z boku, dokonce jestli nebyl SCSI... ale to uz nevim jiste :) http://amiga.erkan.se/index.php/gvp-hd8-vintage-amiga-harddrive/ (kamarad to mel i s rozsirenim pameti a rychlejsim (68020 14MHz?) procesorem, take do GVP, jen ten vypinac na vrchu to nemelo :-)

Jenze 2,5" disky jsou pomale a drahe, takze kutilove odstranili z vnitrnosti Amigy jeden plisek (nad ramkami) a razem se tam dal zcela bezny 3,5" HDD s troskou komprese nacpat. Vsichni to tak meli a nebyli s tim zadne problemy - tedy krome potreby draheho redukcniho kabelu 2,5" - 3,5" IDE. Nebo 2x 3,5" IDE + kablik ven na CDROMku... :) To dokud jsem to nedal cele do toweru a bylo.

OT/

[OT] Jeste jsi zapomnel na Amigu 4000 v provedeni "workstation" (kterou mel tenkrat tatik na praci s videokamerou) ktera byla ulozena v kejsu stejne jako pccka. Samozrejme byla vybavena turbo kartou a troufam si tvrdit, ze to byl tenkrat jeden z nejlepsich pocitacu co tenkrat CSFR bylo k videni... Ale ze by si nekdo vsiml nejakeho zkresleni na monitoru (NECy Ultrascan?) to fakt jako ne... [/OT]

/OT

Tak vzhledem k tomu, jak jsme ted OT jsem nechtel rozebirat jednotlive modely na typy... Treba A3000 se take delala v dvou verzich, ocesane 16MHz a plne 32MHz verzi, pricemz overclock matematickeho koprocesoru 68881 v te 16MHz verzi byl mozny pripajenim pouheho dratku mezi 32MHz nedeleny takt a nadzvednutou nozicku FPU - a svete div se, fungovalo to - 100% overclock, bez chlazeni ci takovych "drobnosti" :D A mam dojem ze se delala i tower verze jako u A3000... http://www.amigau.com/spock/a3000t.html Jo, mam pravdu :) Takze rozebirat to na dalsi varianty nema IMHO cenu. U A4000 se moc o "turbo" kartach neda mluvit, cely CPU byl od zacatku v vymenitelnem slotu a od zacatku se pocitalo s upgradem. Z puvodne 680LC040 na 16MHz se osazeni CPU slot zmenilo casem na dualni procesorovou kartu CyberStormPPC s 68060 na 66Mhz s PowerPC 603e na 233Mhz + hromada (4) ram sloty + specialni CVPPC graficky slot na prime pripojeni grafiky aby to nebrzdila stara sbernice... :) Cize A4k byla od zacatku navrzena na upgrady v CPU casti, stejne jako A1200 a i predchozi modely, jen ne tak masivne :D

OT/

Jak rikam, zkresleni nastava v pripade levnych, nekvalitnich LC filtru. Kdyz jsem vymenil CyberVision64 s Triem a spickove udelanymi CE filtry za CyberVision64/3D s Virge cipem, tak byl rozdil pomalu k zbliti. Musis uvazovat 1024 x 768 v 100Hz, nikoliv 640 x 512 v 50Hz abys videl ten rozdil. Pri nizkych rozlisenich (800 x 600 v 60Hz) si rozdilu na prumerne neostrem monitoru nevsimnes a na LCDcku se ti to snazi "vylepsit" elektronika v monitoru, aby to "bylo ostre", jestlize ho mas pres VGA vystup, coz je docela blbost... Nastaveni LCD monitoru tak, aby se interni "zaostrovace" zcela vyply je docela kumst, treba na BenQ FP75G je to nastaveni Sharpness na 4 ...

(jak logicke je OFF Sharpness pri nastaveni v rozsahu 1 - 5 na 4 at si kazdy posoudi sam)

Tak vzhledem k tomu, jak jsme ted OT jsem nechtel rozebirat jednotlive modely na typy... Treba A3000 se take delala v dvou verzich, ocesane 16MHz a plne 32MHz verzi, pricemz overclock matematickeho koprocesoru 68881 v te 16MHz verzi byl mozny pripajenim pouheho dratku mezi 32MHz nedeleny takt a nadzvednutou nozicku FPU - a svete div se, fungovalo to - 100% overclock, bez chlazeni ci takovych "drobnosti" :D A mam dojem ze se delala i tower verze jako u A3000... http://www.amigau.com/spock/a3000t.html Jo, mam pravdu :) Takze rozebirat to na dalsi varianty nema IMHO cenu. U A4000 se moc o "turbo" kartach neda mluvit, cely CPU byl od zacatku v vymenitelnem slotu a od zacatku se pocitalo s upgradem. Z puvodne 680LC040 na 16MHz se osazeni CPU slot zmenilo casem na dualni procesorovou kartu CyberStormPPC s 68060 na 66Mhz s PowerPC 603e na 233Mhz + hromada (4) ram sloty + specialni CVPPC graficky slot na prime pripojeni grafiky aby to nebrzdila stara sbernice... :) Cize A4k byla od zacatku navrzena na upgrady v CPU casti, stejne jako A1200 a i predchozi modely, jen ne tak masivne :D

OT/

Jak rikam, zkresleni nastava v pripade levnych, nekvalitnich LC filtru. Kdyz jsem vymenil CyberVision64 s Triem a spickove udelanymi CE filtry za CyberVision64/3D s Virge cipem, tak byl rozdil pomalu k zbliti. Musis uvazovat 1024 x 768 v 100Hz, nikoliv 640 x 512 v 50Hz abys videl ten rozdil. Pri nizkych rozlisenich (800 x 600 v 60Hz) si rozdilu na prumerne neostrem monitoru nevsimnes a na LCDcku se ti to snazi "vylepsit" elektronika v monitoru, aby to "bylo ostre", jestlize ho mas pres VGA vystup, coz je docela blbost... Nastaveni LCD monitoru tak, aby se interni "zaostrovace" zcela vyply je docela kumst, treba na BenQ FP75G je to nastaveni Sharpness na 4 ...

(jak logicke je OFF Sharpness pri nastaveni v rozsahu 1 - 5 na 4 at si kazdy posoudi sam)

Virge3D byly tenkrat jedny z nejhorsich karet na trhu cemuz odpovidala cena - ja postupne presel na Voodoo2 (Diamond Monster) kde byla kvalita uplne jinde (myslim tim 2D, ne 3D), pak jsem jeste presel na 2x drazsi Matrox G400 DH 32MB (sice 2x drazsi ale s tema pred tim se to nedalo srovnat - vubec!). Monitor jsem mel v tu dobu iiyamu nebo Eizo 17" (100Hz na 1024x768 si daly urcite, mozna 120Hz), nikdy jsem nemel potrebu pajet do karty - ono si staci jednoduse kartu koupit a tim dosahnout jeste lepsich vysledku - napr. ta matroxa umela menit refresh po 0.5Hz nezavisle na vystupu + bar. korekce... a vubec umela spoustu veci o kterych si mohly nechat ty dve zdat.

edit: Virge3D samozrejme nebyl vyrobce karty ale jeden z cenove dostupnych 3D cipu od S3 (konkurence ala ATI Rage byly za dvojnasobek) - celkem zive si pamatuju jak se k ni pribalovala upravena hra Terminal Velocity kterou to zvladalo v 640x480 s "rozmazavanim textur" coz bylo na tu dobu neco nevidaneho (to muze byt tak 8-9 let zpet)

edit: Virge3D samozrejme nebyl vyrobce karty ale jeden z cenove dostupnych 3D cipu od S3 (konkurence ala ATI Rage byly za dvojnasobek) - celkem zive si pamatuju jak se k ni pribalovala upravena hra Terminal Velocity kterou to zvladalo v 640x480 s "rozmazavanim textur" coz bylo na tu dobu neco nevidaneho (to muze byt tak 8-9 let zpet)

Uhm... mno a cely tohle tema ti ma vlastne rici, ze kvalita 2D zobrazeni byla nizka diky spatnym CE filtrum, ktere kdyz jsi vyradil, tak jsi mel z Virge nadherny obraz a nemusel jsi kupovat jine/nove/drazsi karty kdy jsi postupne vymenoval odpadni CE filtry (Virge, S3) za lepsi (VooDoo, Diamond) az za ty nejlepsi na trhu (G400, Matrox)...

Cela ta pointa je v tom, ze stacilo _JEN_ odpajet CE filtry a bylo po rozmazavani a nekvalite a razem Virge bez filtru predcil Matrox s filtry v kvalite - zadny filtr je vzdy lepsi nez kvalitni filtr, on ten rozsah frekvenci je znacny a co se tyce refreshe po 0,5Hz, tak to mi pripada smesne.

Na Amize jsme meli v Picasso96 nastavenich pro VSECHNY podporovane karty mnohem lepsi nastavenicka:

Jenz se v takto dokonale podobe nedostaly stale ani do nejnovejsich ovladacu nVidie. Specialne moznost si zapnout doublesan pro libovolne rozliseni tam stale chybi a jen globalne se to zapina ci vypina pro VSECHNY nozsi rozliska, coz je napikacu - tady mas presna nastaveni pro 8, 16, 24 a 32 bitu a presto ze to ukazuje jen nizke rozlisko tak si vsimni, po jak malych krocich lze nastavovat clock, coz ti dela nastavovani refreshe...

PS. nektere slabsi karty drive nezvladaly 24 ci 32 bitu v plnych refreshich v vysokych rozlisenich, cize nastavovani zvlaste 8, 16, 24 a 32 bitu ma sva opodstatneni. nVidia advanced timing options se stale, po vice nez 13 letech nechytaji. Trapas.

Cela ta pointa je v tom, ze stacilo _JEN_ odpajet CE filtry a bylo po rozmazavani a nekvalite a razem Virge bez filtru predcil Matrox s filtry v kvalite - zadny filtr je vzdy lepsi nez kvalitni filtr, on ten rozsah frekvenci je znacny a co se tyce refreshe po 0,5Hz, tak to mi pripada smesne.

Na Amize jsme meli v Picasso96 nastavenich pro VSECHNY podporovane karty mnohem lepsi nastavenicka:

Jenz se v takto dokonale podobe nedostaly stale ani do nejnovejsich ovladacu nVidie. Specialne moznost si zapnout doublesan pro libovolne rozliseni tam stale chybi a jen globalne se to zapina ci vypina pro VSECHNY nozsi rozliska, coz je napikacu - tady mas presna nastaveni pro 8, 16, 24 a 32 bitu a presto ze to ukazuje jen nizke rozlisko tak si vsimni, po jak malych krocich lze nastavovat clock, coz ti dela nastavovani refreshe...

PS. nektere slabsi karty drive nezvladaly 24 ci 32 bitu v plnych refreshich v vysokych rozlisenich, cize nastavovani zvlaste 8, 16, 24 a 32 bitu ma sva opodstatneni. nVidia advanced timing options se stale, po vice nez 13 letech nechytaji. Trapas.

Jenomze ty sa tady bavis o Amize na ktery si musel mit nejlepe NECa Multisynca (kvuli tomu, ze zvladal 50Hz na kterym jel defaultne Workbench - az po nastaveni non-interlaced/hi-res rozliseni se monitor prepnul do stavu, kdy byl obraz stabilni a nevrtel se) kvuli jeji neschopnosti prevadet poradne signal na vic nez 50-60Hz (ted se nebavim o A1200 s AGA), ja se bavim o pc, ktery s tim nemelo problem. Kupovani drazsich karet melo vzestupnou tendenci kvuli prechodu z AT na ATX a s tim i souvisejici prechod na AGP. Ona i Voodo mela velmi slusnou kvalitu 2D (ona to byla vlastne 2D karta s pridanym 3D akceleratorem - trosku neco jinyho nez G400). U G400 si vyfasoval na tu dobu profi kartu s takovymi moznostmi, ze to maji az dnesni moderni karty.

[QUOTE]Jenomze ty sa tady bavis o Amize...[/QUOTE]

Ne, o grafickych kartach se tu bavim obecne. Prvni upravu toho druhu jsem delal na Amiga karte, pokracoval jsem na PC kartach s temi stejnymi problemy... Mac grafiky maji take stejne problemy, a tak dale. Jde o obecny problem, ne o problem nejake platformy.

[QUOTE]...na ktery si musel mit nejlepe NECa Multisynca (kvuli tomu, ze zvladal 50Hz na kterym jel defaultne Workbench...[/QUOTE]

Workbench vzdy jel, jede a jet bude v rozliseni, ktere si nastavis. Treba 1280 x 1024 v 120Hz. NEC Multisync byl drahy a zbytecne nekvalitni kram, stacilo mit scandoubler a z 15kHz synchronizacni udelat 30kHz a razem kazdemu druhemu PC monitoru 50Hz refresh nevadil. Vadil hlavne 15kHy sync, v DOSu mas refresh podle typu karty mezi 56 a 60Hz... Eizo davalo 100x lepsi obraz nez NEC Multisync, bylo krasne ostry i ve vysokych rozliskach a diky super nastaveni Amigy bylo proste nadherny.

[QUOTE]....kvuli jeji neschopnosti prevadet poradne signal na vic nez 50-60Hz (ted se nebavim o A1200 s AGA)[/QUOTE]

Znovu opakuji, ze 50 ci 60Hz nevadilo, vadil PAL vystup (jak kde, v TV byl zadan a vitan) s 15kHz syncem. Mixujes tu jabka a hrusky.

[QUOTE]...ja se bavim o pc, ktery s tim nemelo problem...[/QUOTE]

A ja ti rikam, ze melo a kua velky. Vlastne ma dodnes. Zkus si 1280 x 1024 v 100Hz a na 90% karet bude obraz mazly jak strelena svine. Cetl jsis prosimte vubec co jsem napsal? :rolleyes:

Ne, o grafickych kartach se tu bavim obecne. Prvni upravu toho druhu jsem delal na Amiga karte, pokracoval jsem na PC kartach s temi stejnymi problemy... Mac grafiky maji take stejne problemy, a tak dale. Jde o obecny problem, ne o problem nejake platformy.

[QUOTE]...na ktery si musel mit nejlepe NECa Multisynca (kvuli tomu, ze zvladal 50Hz na kterym jel defaultne Workbench...[/QUOTE]

Workbench vzdy jel, jede a jet bude v rozliseni, ktere si nastavis. Treba 1280 x 1024 v 120Hz. NEC Multisync byl drahy a zbytecne nekvalitni kram, stacilo mit scandoubler a z 15kHz synchronizacni udelat 30kHz a razem kazdemu druhemu PC monitoru 50Hz refresh nevadil. Vadil hlavne 15kHy sync, v DOSu mas refresh podle typu karty mezi 56 a 60Hz... Eizo davalo 100x lepsi obraz nez NEC Multisync, bylo krasne ostry i ve vysokych rozliskach a diky super nastaveni Amigy bylo proste nadherny.

[QUOTE]....kvuli jeji neschopnosti prevadet poradne signal na vic nez 50-60Hz (ted se nebavim o A1200 s AGA)[/QUOTE]

Znovu opakuji, ze 50 ci 60Hz nevadilo, vadil PAL vystup (jak kde, v TV byl zadan a vitan) s 15kHz syncem. Mixujes tu jabka a hrusky.

[QUOTE]...ja se bavim o pc, ktery s tim nemelo problem...[/QUOTE]

A ja ti rikam, ze melo a kua velky. Vlastne ma dodnes. Zkus si 1280 x 1024 v 100Hz a na 90% karet bude obraz mazly jak strelena svine. Cetl jsis prosimte vubec co jsem napsal? :rolleyes:

[QUOTE=trodas;259948]Zkus si 1280 x 1024 v 100Hz a na 90% karet bude obraz mazly jak strelena svine. Cetl jsis prosimte vubec co jsem napsal? :rolleyes:[/QUOTE]

Na 19" Eizu na tomhle rozliseni beham a v klidu - nikde nic nezaostrenyho (rohy apod...), na 21" F931 to same, ani v 1600x1200@100 nic. Srovnavam s Fujitsu-Siemens 19" PVA panelem ;)

GK MSI (!) 8800 GTS (G80 jadro)

Problem "maznutych" monitoru je vetsinou vina spatne serizenych monitoru nebo jejich limitaci - 90% monitoru ma totiz presne tyhle problemy s rozmazanim rostouci s frekvenci. Napr. na HP monitorech (obrazovky Sony, Diamondtron) je doporucena/ergonomicka frekvence 85Hz pri niz jke obraz ostry, ale blika jako ..... a pri 100Hz zase neni ostry nebo se neni ostry v nekterem z rohu.

Me by zajimalo jestli si to zkousel s nejakou novou kartou do PCIE :notsure (mozna by stala za pokus nejaka hruza ala FX5200 apod.)

Dale by nebylo od veci se podivat na G400 DualHead jestli ma na sobe filtry, G550, popr. Parhelia ;)

Na 19" Eizu na tomhle rozliseni beham a v klidu - nikde nic nezaostrenyho (rohy apod...), na 21" F931 to same, ani v 1600x1200@100 nic. Srovnavam s Fujitsu-Siemens 19" PVA panelem ;)

GK MSI (!) 8800 GTS (G80 jadro)

Problem "maznutych" monitoru je vetsinou vina spatne serizenych monitoru nebo jejich limitaci - 90% monitoru ma totiz presne tyhle problemy s rozmazanim rostouci s frekvenci. Napr. na HP monitorech (obrazovky Sony, Diamondtron) je doporucena/ergonomicka frekvence 85Hz pri niz jke obraz ostry, ale blika jako ..... a pri 100Hz zase neni ostry nebo se neni ostry v nekterem z rohu.

Me by zajimalo jestli si to zkousel s nejakou novou kartou do PCIE :notsure (mozna by stala za pokus nejaka hruza ala FX5200 apod.)

Dale by nebylo od veci se podivat na G400 DualHead jestli ma na sobe filtry, G550, popr. Parhelia ;)

[QUOTE=trodas;259948]A ja ti rikam, ze melo a kua velky. Vlastne ma dodnes. Zkus si 1280 x 1024 v 100Hz a na 90% karet bude obraz mazly jak strelena svine. Cetl jsis prosimte vubec co jsem napsal? :rolleyes:[/QUOTE]

A co teprve 1600×1200 nebo ještě víc...no kupodivu když člověk použije jen jeden monitor (HD 3870), v 1600×1200×100 Hz se na to dá ještě dobře koukat...ale třebas 2048×1536×85 Hz :)

A co teprve 1600×1200 nebo ještě víc...no kupodivu když člověk použije jen jeden monitor (HD 3870), v 1600×1200×100 Hz se na to dá ještě dobře koukat...ale třebas 2048×1536×85 Hz :)

Richmond - ach jo... Problem, pokud nemas vyslovene spatny monitor/kabely neni v monitoru, ale v CE filtrech... Pokud mas CE filtry a jeste spatny monitor, tak samo... nazdarek, kocarek :)

[QUOTE]Me by zajimalo jestli si to zkousel s nejakou novou kartou do PCIE[/QUOTE]

Samozrejme. Dokud jde vystup pred CE filtry, je rozmazavan. Tecka.

[QUOTE]Me by zajimalo jestli si to zkousel s nejakou novou kartou do PCIE[/QUOTE]

Samozrejme. Dokud jde vystup pred CE filtry, je rozmazavan. Tecka.